Le 16 juillet 2019, Elon Musk annonce lors d’un discours à l’Académie des Sciences de Californie, qu’avec Neuralink, compagnie qu’il fonde en 2016, il a pour ambition que l’humain fusionne avec l’intelligence artificielle, ce qui donnerait accès à une forme supérieure d’intelligence. Scénario catastrophe digne des plus grands films de science-fiction, ou alors futur des possibles avec un homme augmenté, l’IA crée débat. Notamment car elle n’a pas de définition unanimement acceptée, néanmoins, d’après l’Encyclopédie Larousse, elle est l’« Ensemble de théories et de techniques mises en œuvre en vue de réaliser des machines capables de simuler l’intelligence humaine. ». Est déjà esquissée, dans cette simple définition, la complexité du domaine en ce qui concerne la propriété intellectuelle.

Qu’en est-il de la PI ?

L’IA est le futur de secteurs stratégiques, notamment dans le transport, l’agriculture, ou encore le bâtiment et les technologies de l’information et de la communication. Pour encourager les innovateurs qui vont investir dans ce domaine, il faut une garantie : celle de la protection solide et sans faille de leur invention. Mais en ce qui concerne l’IA, le champ de protection de la PI peut sembler flou. En effet, on peut protéger grâce au brevet une solution technique à un problème technique, des dessins et modèles et des bases de données avec le droit d’auteur, ou encore des logiciels. Seulement, la PI ne protège pas les algorithmes, considérés comme des méthodes mathématiques ; or les algorithmes sont le fondement des inventions se servant de l’IA La PI est-elle remise en cause par l’IA ?

Du côté des États-Unis, jusqu’à la décision de justice Alice, l’USPTO délivrait relativement facilement les brevets portant sur les logiciels. Alice mettra fin à ce laxisme quant à la brevetabilité de logiciels en 2015. Aujourd’hui, les objets brevetables doivent se soumettre au test Alice/Mayo (Alice Corp. V. CLS Bank, Mayo Collaborative v. Prometheus Labs.). Les États-Unis conservent cependant une position plus ouverte quant aux demandes de brevet mettant en œuvre de l’IA.

En Chine, l’Office chinois des brevets a statué d’un assouplissement certain des conditions de brevetabilité. Par exemple, les méthodes commerciales peuvent être brevetées… tant qu’elles présentent un aspect technique, et ne sont plus systématiquement inéligibles à la brevetabilité.

Dans les nouvelles Directives d’examen, le procédé n’est plus le passage obligé et il est désormais autorisé de rédiger des revendications de support pour programme d’ordinateur. En effet, les nouvelles Directives d’examen distinguent de façon plus claire la notion de « programme d’ordinateur per se », qui n’est pas brevetable selon l’Article 25 de la loi de brevet, et une invention relative au programme d’ordinateur. Ainsi, les Directives permettent désormais de rédiger une revendication de la forme « média + processus d’un programme d’ordinateur » (II.IX – 2).

Finalement, dans le domaine de l’IA, les concepts bougent constamment, la capacité d’innovation est très courte, il y a des avancées très fréquentes. D’un autre côté, la PI a besoin de stabilité. Le temps d’obtenir un brevet peut s’avérer très long, le processus est même beaucoup trop long par rapport à l’IA Il y a en effet une collision entre les constantes de temps de l’IA et de PI Les technologies se renouvelant très vite, le temps d’obtenir un brevet, la technologie est déjà dépassée. L’IA peut donc à la fois représenter un risque, remettant en cause le système actuel de PI, et un atout, dans la mesure où elle pourra rédiger et délivrer des brevets beaucoup plus rapidement que l’Homme. Certes, elle remet en cause, mais elle fournit aussi une nouvelle manière de faire, avec un droit plus sûr car application d’une série de règles préenregistrées, et fournira peut-être une solution qui permettrait de synchroniser les dynamiques d’IA d’un côté et de PI de l’autre.

Une nécessité de restructuration européenne dans le domaine de l’IA

Pour soutenir, booster, et protéger les inventions et les innovateurs en Europe, notamment dans l’IA, il est nécessaire de poser et/ou de renforcer des bases stables, et de mener des politiques ambitieuses. Tout d’abord, les entreprises ont besoin de financements, et ce pour toutes les étapes avant leur lancement sur le marché (études de faisabilité, R&D, amorçage, innovation, communication…). Ensuite, il faut une réelle communication sur les moyens de financements, pour que les start-up aient conscience des différentes aides existantes, et surtout osent en demander. De plus, il faut un accompagnement, avec un réseau d’experts mis à disposition, des incubateurs et accélérateurs, en fonction de la maturité de la start-up. Enfin, il faut quadriller le territoire en donnant accès à ces ressources au maximum de personnes, même celles qui sont en périphérie des centres dynamiques.

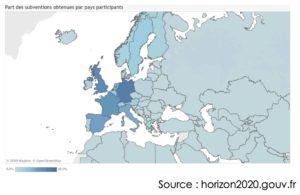

L’Europe a aussi besoin de rassembler ses efforts. Le programme Horizon 2020, qui regroupe les financements de l’Union européenne en matière de recherche et d’innovation, va notamment dans ce sens. En effet, d’une part, ont été mis en place les Digital Innovation Hubs dans le domaine de l’IA, qui sont des plateformes qui ont pour but de rassembler des spécialistes, qui proposent une aide technique, légale, administrative, business, en lien fort avec les académies, les entrepreneurs, les industries, les incubateurs, les investisseurs, et la communauté des utilisateurs actifs et potentiels. D’autre part, est affirmée la volonté de rassembler les Européens autour de leurs valeurs, telles que l’ouverture, la neutralité, la transparence, la protection des données et de la vie privée. Avec une volonté de coopération internationale, Horizon 2020 a donc pour objectif de transformer l’industrie et les services européens, notamment à travers l’IA, pour que l’Europe se serve de son leadership pour en faire un leadership dans l’innovation et l’entrepreneuriat.

La France a notamment bénéficié de 11,1% des subventions, soit un total de 4,8 Md €

Pour aller plus loin …

Des problèmes éthiques ?

Avec l’IA, il y a d’une part la tentation de renoncer à l’interprétation humaine par paresse, par facilité. En effet, si jamais une intelligence artificielle, au moment d’un jugement, faisait des recommandations et l’on ne suivait que celles-ci, cela poserait problème, rendant les jugements froids et la prise en compte de paramètres humains moins importante.

D’autre part, la prise de décision dans une situation d’urgence peut elle aussi poser problème : si lors d’un accident, une voiture devait obligatoirement soit percuter un individu A, soit un individu (ou un groupe d’individus) B, vers où se dirigerait-elle ? Quels critères prendrait-elle en compte ? Doit-elle en prendre en compte ?

Enfin, cela serait épineux dans le domaine des assurances : l’assurance peut couvrir que le non prévisible. Cependant, avec de nouvelles solutions d’IA, on arrive à réduire de plus en plus la part d’incertitude : par exemple, sur les chances d’avoir un cancer. On ne pourra donc plus assurer ce risque en mutualisant les coûts. Cela aura un effet de bascule entre mutualisation (avec des risques aléatoires) à une individualisation des coûts.

Finalement, l’IA en soi ne crée pas de problème éthique, mais ce sont les utilisations des technologies d’IA qui posent problème.

Faut-il réguler alors l’IA ?

Cette question divise. Nous allons donc présenter deux points de vue

1er point de vue : réguler, c’est asphyxier…

Le droit romain est un droit qui édicte des principes généraux, et applique ces derniers à chaque cas. Le droit anglo-saxon conçoit des lois précises pour chaque cas. Ainsi, vouloir réguler l’IA relèverait d’une logique de droit anglo-saxon. On pense que la régulation permet notre protection ainsi que celle de nos intérêts. Seulement, d’un point de vue économique, cela freine d’une part les industriels européens dans leurs projets ; d’autre part, croire que cela freine le déploiement des entreprises étrangères sur le territoire européen n’est qu’une illusion. En Europe, cette tendance à réguler fait suffoquer certaines branches, réduit les libertés d’action et d’expression des possibilités d’une innovation.

Le risque ne réside pas en soi dans la technologie, mais dans ses utilisations. Vouloir réguler ce domaine paralyse les efforts de recherche et développement. Il y a finalement moins de barrières pour les États-Unis et la Chine afin de se développer en Europe, car ils rencontreront moins d’obstacles règlementaires. Au-delà de ce premier aspect, les scientifiques ont conscience du potentiel d’action en fonction de la législation sur un territoire. Ils ne voudront pas travailler dans des structures où on leur met des bâtons dans les roues, ce qui va encore plus avantager les États-Unis, qui vont attirer cette fuite de cerveaux.

Il s’agirait alors de ne pas chercher à tout réguler, et d’appliquer le droit commun : si le rendu d’un travail a été mal conçu, ou ne répond pas à des normes générales (éthiques, d’hygiène…), le responsable répare la faute commise, comme dans tout autre domaine.

Étant dans une ère où la technologie va plus vite que le régulateur, l’action de ce dernier risque de bloquer les avancées plus qu’autre chose.

2nd point de vue : réguler, c’est donner du sens

Les systèmes d’intelligence artificielle traitent les données mieux que n’importe quel humain lorsqu’il s’agit d’utiliser des calculateurs ou des capteurs. Ils sont un modèle d’efficacité dans l’objectivité : ils ne sont pas sensibles à la fatigue, à la maladie, ou encore au manque d’attention, contrairement à l’humain. Ces outils sont orientés vers la performance avec des capacités de calcul toujours plus puissantes, notamment avec le deep learning, et cette logique s’oriente vers une quête d’efficacité pour la société. Seulement, une société est une entité circonstancielle et relative, avec des normes différentes, des visions qui évoluent, des rapports internes et externes changeants. Ainsi, l’IA tend plus vers l’éthique que la morale.

En effet, un algorithme d’IA est une projection de la vision sociale et sociétale du programmeur à un instant t, et on y devine l’expression d’une œuvre de l’esprit. C’est un objet créé avec une subjectivité humaine : l’humain entre dans la boucle du logiciel. Le code d’IA présente alors une irrationalité certaine : le programmeur code ce que lui pense qui est bien. Cela peut donc bien évidemment entraîner des questions éthiques. Par exemple, si un système d’IA conduit une voiture, et un véhicule arrive en trombe en face de lui, deux choix s’offrent à lui : doit-il jeter la voiture dans le fossé et donc potentiellement tuer son patron, ou alors faire en sorte que lui survive aux éventuels dépens du conducteur en face ? La réponse dépendra des cultures, des éducations, des vécus.

C’est pourquoi il est important de réguler selon des principes généraux de morale, en fonction des cas, et débattre, apprendre, alimenter ces réglementations. Mais cela pose encore le problème de la paralysie des efforts dus à la régulation.

En effet, réguler son propre pays et mettre en place des législations contraignantes est souvent pénalisant, comme énoncé dans le premier point de vue sur la régulation.

Ikram Lisa Baba Ali Turqui Entretiens avec

Pierre Breesé & Sylvain Allano

Sources :

https://www.scientificamerican.com/article/elon-musks-secretivebrain-tech-company-debuts-a-sophisticated-neural-implant1/

https://www.wipo.int/wipo_magazine/fr/2018/05/article_0001.html

https://www.forbes.fr/entrepreneurs/brevets-et-propriete-industriellece-que-la-loi-pacte-va-changer/?cn-reloaded=1

https://www.wipo.int/wipo_magazine/fr/2010/06/article_0010.htm https://www.institutmolinari.org/IMG/pdf/cahier1008_fr.pdf